Advances in Applied Mathematics

Vol.

08

No.

10

(

2019

), Article ID:

32465

,

5

pages

10.12677/AAM.2019.810186

Tensor Denoising Based on Truncated Nuclear Norm

Xiaoting Feng, Tingting Ma

School of Mathematics, Liaoning Normal University, Dalian Liaoning

Received: Sep. 24th, 2019; accepted: Oct. 4th, 2019; published: Oct. 11th, 2019

ABSTRACT

Based on the problem of tensor nuclear norm, a new robust principal component analysis model is established by substituting truncated nuclear norm for nuclear norm, and the convex optimization problem is solved by augmented Lagrange multiplier method. In the experiment of image denoising, the robust principal component analysis model with truncated unclear norm has good denosing effect.

Keywords:Truncated Nuclear Norm, Augmented Lagrange Multipliers, Tensor Singular Value Decomposition, Image Denoising

基于截断核范数的张量去噪

冯晓亭,马婷婷

辽宁师范大学数学学院,辽宁 大连

收稿日期:2019年9月24日;录用日期:2019年10月4日;发布日期:2019年10月11日

摘 要

基于张量核范数问题,用截断核范数代替核范数,建立一个新的截断核范数鲁棒主成分分析(Truncated Nuclear Norm Robust Principal Component Analysis, TNNRPCA)模型,并使用增广拉格朗日乘子法对这个凸优化问题求解。在图像去噪的实验过程中,截断核范数的鲁棒主成分分析模型去噪效果好。

关键词 :截断核范数,增广拉格朗日乘子法,张量奇异值分解,图像去噪

Copyright © 2019 by author(s) and Hans Publishers Inc.

This work is licensed under the Creative Commons Attribution International License (CC BY).

http://creativecommons.org/licenses/by/4.0/

1. 引言

随着稀疏与低秩知识的深入,主成分分析模型 [1] 对于低秩矩阵恢复潜力巨大,但由于主成分分析模型中的特征值分解有一些局限性,并且在非高斯分布情况下,主成分分析模型得出结果可能并不是最优的。Candès等 [2] 将主成分分析推广到了鲁棒主成分分析(Robust Principal Component Analysis, RPCA) [3] 模型。

由于矩阵的秩非凸,且函数不连续,RPCA构建的模型为一个NP-Hard的优化问题,不易求解。所以引入核范数鲁棒主成分分析 [4] ,该算法对矩阵中的不同奇异值求和,优化时有相同的惩罚力度。但在不同大小的奇异值中,前 个较大的奇异值在核范数中起了主要作用,所以核范数在图像去噪方面效果仍不是特别理想,导致实际问题中求出的模型的次优解。为更精确刻画低秩的部分,Hu [5] 等人提出截断核范数的概念,构建截断核范数优化模型,弥补了核范数的不足,使求解后的张量数据恢复的更好。在现有文献基础上,将矩阵鲁棒主成分分析方法运用于高维数据去噪,这种基于矩阵鲁棒主成分分析模型的方法对于结构简单的高维数据,具有较好的去噪效果。因此我们在张量中的模型是基于张量奇异值分解(Tensor Singular Value Decomposition, t-SVD) [6] 和张量截断核范数的鲁棒主成分分析,它的目的是通过求解一个目标为张量截断核范数与 范数加权组合的模型,可以精确地恢复一个被稀疏误差损坏的低秩张量。

2. 预备知识

定义1 [7] 张量 的核范数记为 ,表示 所有正面切片核范数的平均值,即:

(1)

定义2 [8] 张量 的截断核范数记为 ,被定义为:

(2)

其中 , 是由t-SVD生成的,其中 和 分别为t-SVD中的 和 在第二维度中的前r列。

定义3 [7] 已知 可以进行t-SVD,要使得 满足带有参数 的张量非相干条件,则需满足:

(3)

(4)

和

(5)

定理1 [1] 设 的t-SVD为:

(6)

是正交的, 是f-对角张量。

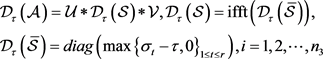

引理1 [8] 已知张量 的t-SVD为 ,奇异阈值算子定义为:

(7)

(7)

3. 截断核范数的鲁棒主成分分析

3.1. 模型的建立

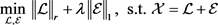

已知一个数据张量 ,假设张量可以通过t-SVD分解成低秩分量 和稀疏分量 ,核范数鲁棒主成分分析模型如下式所示:

(8)

(8)

其中 。

式(8)中, 为张量 的核范数,根据张量的奇异值分解,在核范数最小化问题中,所有的奇异值同时被最小化,这样不能对原始张量进行很好地秩估计。为了保证数据不被过多丢失,增强模型鲁棒性,用截断式核范数代替核范数,构建了基于张量截断核范数与 范数的鲁棒主成分分析模型,如式(9)所示:

(9)

(9)

3.2. 模型的求解

根据定义2且引入辅助变量 ,得到优化问题(9)的如下形式:

(10)

对式(10)构建增广拉格朗日函数:

(11)

其中张量 为拉格朗日乘子,惩罚系数 。

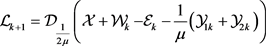

使用交替方向法迭代更新张量 和惩罚系数 。求解目标函数的详细流程如下:

固定 ,更新 :

(12)

根据引理1,(12)式可以化简为:

(13)

(13)

固定 ,更新 :

(14)

通过软阈值收缩算子,可以转化为:

(15)

固定 ,更新 :

(16)

(16)式为关于 的二次项,令其导数为0,可得到闭式解。去掉无关项得:

(17)

求导:

(18)

(19)

更新 , :

(20)

4. 实验

实验将本文模型与TRPCA、TNNR、SNN这 3个模型作比较,选取图片大小 ,椒盐噪声为20%的彩色图片。通过对比彩色图片的恢复情况,得到张量去噪模型的恢复效果。下面列出在单张彩色图片上这四种模型恢复上的效果,如图1所示。同时为了准确评估算法之间恢复的效果,采用峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)来衡量四种模型在相同噪声情况下数据的高低,其中PSNR越高,噪声数据恢复的效果越好,数据如表1所示。

原始图片

原始图片

噪声图片

噪声图片

TRPCA

TRPCA

TNNR

TNNR

SNN

SNN

TNNRPCA

TNNRPCA

Figure 1. Comparison of denoising effects of different methods

图1. 不同方法去噪效果对比

Table 1. Data denoised by each algorithm

表1. 各算法去噪后的数据

5. 结论

当初始条件相同时,通过图1得出,TRPCA、TNNR、SNN模型恢复出来的彩色图片与原始彩色图片有一定区别。而本文模型对张量数据的恢复更接近于原始彩色图片,即说明使用截断核范数的方法可以有效去除较大奇异值对于噪声产生的不良影响。通过表1数据显示,在相同噪声情况下,本模型PSNR要高于其他模型,同时在迭代次数以及迭代时间上都优于其他模型,实验结果证明本文所建模型的有效性和可行性。总体上来说,TNNRPCA能够比较准确地恢复出彩色图片。

文章引用

冯晓亭,马婷婷. 基于截断核范数的张量去噪

Tensor Denoising Based on Truncated Nuclear Norm[J]. 应用数学进展, 2019, 08(10): 1592-1596. https://doi.org/10.12677/AAM.2019.810186

参考文献

- 1. Jolliffe, I. (2002) Principal Component Analysis. Wiley Online Library, New York.

- 2. Bouwmans, T. and Zahzah, E.H. (2014) Robust PCA via Principal Component Pursuit: A Review for a Comparative Evaluation in Video Surveillance. Computer Vision and Image Understanding, 122, 22-34.

- 3. Candès, E.J., Li, X., Ma, Y. and Wright, J. (2011) Robust Principal Component Analysis? Journal of the ACM (JACM), 58, 11.

https://doi.org/10.1145/1970392.1970395 - 4. Xie, Y., Gu, S., Liu, Y., Zuo, W., Zhang, W. and Zhang, L. (2016) Weighted Schatten $ p $-Norm Minimization for Image Denoising and Background Subtraction. IEEE Transactions on Image Processing, 25, 4842-4857.

https://doi.org/10.1109/tip.2016.2599290 - 5. Hu, Y., Zhang, D., Ye, J., Li, X. and He, X. (2012) Fast and Accurate Matrix Completion via Truncated Nuclear Norm Regularization. IEEE Transactions on Pattern Analysis and Machine Intelligence, 35, 2117-2130.

https://doi.org/10.1109/tpami.2012.271 - 6. Kilmer, M.E. and Martin, C.D. (2011) Factorization Strategies for Third-Order Tensors. Linear Algebra and Its Applications, 435, 641-658.

https://doi.org/10.1016/j.laa.2010.09.020 - 7. Lu, C., Feng, J., Chen, Y., Liu, W., Lin, Z. and Yan, S. (2016) Tensor Robust Principal Component Analysis: Exact Recovery of Corrupted Low-Rank Tensors via Convex Optimization. 2016 Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, 27-30 June 2016, 5249-5257.

https://doi.org/10.1109/cvpr.2016.567 - 8. Xue, S., Qiu, W., Liu, F. and Jin, X. (2017) Low-Rank Tensor Completion by Truncated Nuclear Norm Regularization. arXiv preprint arXiv:1712.00704

https://doi.org/10.1109/icpr.2018.8546008