Operations Research and Fuzziology

Vol.

14

No.

01

(

2024

), Article ID:

80610

,

9

pages

10.12677/ORF.2024.141003

用于超声图像分割的自适应混合注意力算法

徐梦琪

南京信息工程大学数学与统计学院,江苏 南京

收稿日期:2023年11月2日;录用日期:2023年11月22日;发布日期:2024年2月7日

摘要

乳腺超声图像通常包含丰富的结构和纹理,并且这些结构具有不同的形状、大小和对比度,所以准确分割出乳腺超声图像中的病灶区域是一项具有挑战性的任务。在本研究中,我们提出了一种创新的方法,旨在提高乳腺超声图像分割任务的性能。我们的方法结合了混合注意力编码器和自适应深度监督技术,可以有效地处理乳腺超声图像的复杂结构和多尺度信息。首先,我们提出的混合注意力模块引入了空间和通道注意力机制,用于更好地捕获图像的空间信息和通道特征。其次,我们采用了深度监督技术使解码器输出不同尺度大小的分割图,每个分割结果与真实标签计算损失。最后,我们引入了混合损失函数,将多尺度分割结果结合在一起,使模型自动权衡不同尺度信息的重要性。大量实验表明,我们的网络在定量分析和视觉效果方面都提高了乳腺超声图像分割的性能。

关键词

超声图像,图像分割,注意力机制,深度监督

An Adaptive Hybrid Attention Algorithm for Ultrasonic Image Segmentation

Mengqi Xu

School of Mathematics and Statistics, Nanjing University of Information Science and Technology, Nanjing Jiangsu

Received: Nov. 2nd, 2023; accepted: Nov. 22nd, 2023; published: Feb. 7th, 2024

ABSTRACT

Breast ultrasound images often contain a wealth of structures and textures, and these structures have different shapes, sizes, and contrasts; so accurately segmenting focal areas in breast ultrasound images is a challenging task. In this study, we propose an innovative approach aimed at improving the performance of the breast ultrasound image segmentation task. Our approach combines hybrid attention encoders and adaptive deep supervision techniques to efficiently process the complex structure and multi-scale information of breast ultrasound images. Firstly, our proposed hybrid attention module introduces spatial and channel attention mechanisms to better capture spatial information and channel features of images. Secondly, we use the deep supervision technique to make the decoder output the segmentation graph of different scales, and calculate the loss of each segmentation result with the real label. Finally, we introduce a mixed loss function to combine the multi-scale segmentation results so that the model can automatically weigh the importance of information at different scales. A large number of experiments have shown that our network improves the performance of breast ultrasound image segmentation in both quantitative analysis and visual effects.

Keywords:Ultrasonic Image, Image Segmentation, Attention Mechanism, Deep Supervision

Copyright © 2024 by author(s) and Hans Publishers Inc.

This work is licensed under the Creative Commons Attribution International License (CC BY 4.0).

http://creativecommons.org/licenses/by/4.0/

1. 引言

乳腺癌是女性中最常见的肿瘤之一,也是全球女性健康的严重威胁之一,它涉及生理、心理、社会和经济层面的各种挑战。早期检测、定期筛查和综合的治疗方案可以减轻这些威胁,并提高乳腺癌患者的生存率和生活质量。所以乳腺癌的早期诊断和及时治疗对于提高患者的生存率和生活质量至关重要。在临床实践中,医学影像学已经成为乳腺癌诊断的重要工具之一,其中乳腺超声图像分割在医学诊断、临床研究和病理分析中具有重要意义 [1] 。例如,超声图像分割可以帮助医生准确定位病变区域,判断肿瘤的良恶性,使诊断和治疗计划更加简便。然而,由于医疗设备的局限性和生物组织的特性,超声图像往往会受到各种噪声的干扰,如伪影和斑点噪声。此外,超声图像的对比度通常较低,不同组织之间存在细微的灰度差异,这给辨别病变的边缘和形状带来了挑战。由于上述问题,准确分割超声图像中的病变是一项艰巨的任务,因此设计高效的算法来提高乳腺超声图像的分割精度是非常必要的。

早期的医主学图像分割要由人工完进行成,但是人工医学图像分割耗时耗力并且对分割人员的专业水平有着很高的要求。近年来,深度学习技术在医学图像处理领域取得了显著的进展,为自动化乳腺肿瘤图像分割提供了新的机会。深度学习模型可以从大规模数据中学习图像的特征和模式,并具备出色的泛化能力,使其成为自动分割的有力工具 [2] 。在这一背景下,U-Net [3] 模型作为一种卷积神经网络架构,以其在医学图像分割任务中的卓越性能而备受瞩目,U-Net是一种广泛应用于图像分割的神经网络架构,具有编码器–解码器结构,其中编码器提取图像特征,解码器生成分割结果。UNet++ [4] 在U-Net的基础上进行了扩展,引入了嵌套和级联架构的概念,通过渐进式连接将多层次的每个编码器和解码器连接起来,促进了信息传播,提高了分割精度。Res-UNet [5] 在U-Net的基础上引入了残差连接,缓解了梯度消失问题,加快训练速度。通过利用残差连接,该网络可以在更深的层次上学习更丰富的特征表征。

尽管CNNs在图像处理方面发挥了很大的作用,但是在乳腺超声图像分割方面仍存在许多困难。首先,乳腺组织具有不同的声波反射特性,这使得超声图像中的亮度和纹理分布不均匀,从而增加分割算法的复杂性。其次,乳腺组织具有复杂的结构特征,这使得分割过程中辨识不同的组织类型更具挑战性。此外,由于成像设备的不同,乳腺超声图像可能包含噪声,这些噪声可以干扰分割算法的性能,使其难以准确地检测和分割组织结构。最后,在乳腺超声图像中,正常组织和异常组织的比例通常不平衡,这可能导致分割算法对正常组织的分割性能较好,而对异常组织的分割性能不佳。这些困难也限制了CNNs在超声图像分割中的应用,所以对神经网络进行创新以提高图像分割的性能是非常必要的。

2. 超声图像分割的发展

2.1. 深度学习在超声图像分割中的应用

近年来,深度学习在计算机视觉领域取得了突破性进展。神经网络在不断发展,新的模型和框架不断被提出,在各种任务中不断刷新纪录。CNNs擅长自动学习图像特征,从医学影像中有效提取有价值的信息,以及执行像素分类或分割。它们减少了人工干预的需要,同时提高了计算机视觉任务的效率,尤其是在图像分类和语义分割方面。在医学图像分割领域,常见的任务包括肿瘤分割、器官分割和病变区域划分。例如,Gao等人提出了一种协方差自注意双路径UNet框架,通过获取跨尺度的丰富细粒度和粗粒度语义信息来增强模型的表示 [6] 。然而,它缺乏从具有大量噪声的病变中有效提取特征的能力。Ning等人提出了一种用于BUS图像中肿瘤分割的显著性引导形态学感知UNet,分别学习前景和背景的显著性 [7] 。Zhao等人提出了一种基于先验注意力的多类医学图像分割方法,通过在单个网络中结合两阶段分割,在肺部肿瘤分割中取得了良好的效果,但它往往需要分割目标的显式先验知识 [8] 。

大多数的神经网络也面临以下的问题:首先,通过大量的共享权值的卷积操作,CNNs对于病灶边界模糊或图像质量不清晰的物体的特征识别不够敏感,从而影响细节特征的提取能力。其次,CNNs通常包含大量不同尺度的特征图,但它们对于病灶的分割有不同的重要性,所以缺乏对重要特征通道的关注度。最后,对于复杂多样的病灶种类和形状位置变化大的物体,CNNs对来自不同操作下的特征信息的融合能力不足,所以不能准确的分割出完整的病灶,这些难点也限制了CNNs在临床医学中的应用。

2.2. 注意力机制在神经网络中的优势

医学图像分割任务中常常存在类别不平衡的问题,即不同类别的像素数量差异较大。注意力机制可以通过学习类别之间的相关性和重要性,自适应地调整不同类别的权重。这有助于提高对少数类别的分割准确性,解决类别不平衡问题。此外,医学图像中的结构和病变边界通常是模糊和不清晰的,尤其是在低对比度图像或噪声较多的情况下。注意力机制可以帮助网络更加关注边界区域,提高边界细化的能力。这对于准确分割器官边界和病变边界非常重要,有助于临床诊断和治疗的精确性。例如,He等人提出了用于乳腺超声图像分割的混合CNN变压器网络,将变压器和注意力机制加入到网络中促进超声图像分割,但是对于边缘的分割不够清晰 [9] 。Oktay等人在U-Net中引入了注意力门控机制,使模型能够集中注意力于感兴趣的区域,用于胰腺检测任务 [10] 。Hou等人提出了一种融入双注意力模块的U-Net肺结节图像分割方法,来解决肺结节分割的任务中特征提取复杂等问题,但是对于病灶的形状约束欠缺 [11] 。

注意力机制允许模型在处理输入数据时更加集中和有针对性,可以将更多的“注意力”集中在重要的特征或区域上,这对于处理复杂的、多维度的数据非常有用。其次,注意力机制在不同任务和场景中具有高度的灵活性,可以根据任务的要求自动学习权重,而不需要手动进行特征工程。此外,注意力机制能够提供模型的可解释性,使模型的决策更具可理解性。通过查看注意力分布,可以了解模型对输入的哪些部分给予了更多的关注。总的来说,注意力机制是深度学习领域的一个重要创新,已经在多个领域取得了显著的成功,并提供了一种有效的方式来处理大规模、复杂和多模态的数据。这些优势使得注意力机制在神经网络中得到广泛的应用和创新,提高了神经网络的性能,也成为了许多深度学习应用中不可或缺的部分。

3. 方法

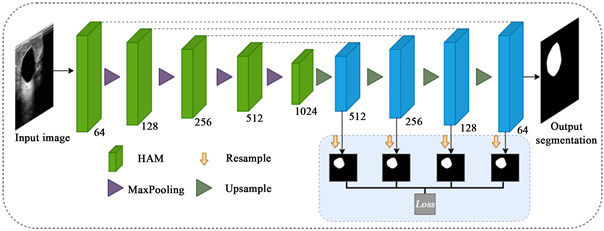

3.1. 整体网络架构

如下图(见图1)所示,是我们提出的自适应混合注意力网络,它的核心架构是U-Net。不同的是,我们在编码器部分提出了混合注意力模块(HAM)来取代原有的下采样操作,并且在解码器部分加入了自适应深度监督技术,以更好的适应乳腺病变的分割。下面我们将具体说明每个模块的详细信息以及优势所在。

Figure 1. Overall architecture of adaptive hybrid attention networks

图1. 自适应混合注意力网络的整体架构

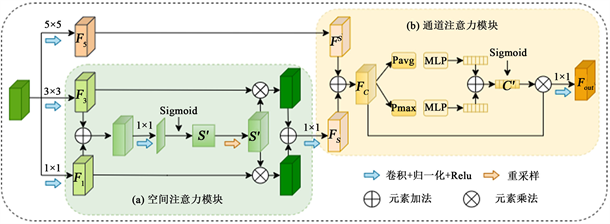

Figure 2. Hybrid attention module

图2. 混合注意力模块

3.2. 混合注意力模块(HAM)

HAM模块(见图2)主要由两部分组成:空间注意力机制和通道注意力机制。具体来说,输入的超声图像经过不同卷积核大小的卷积操作得到三种不同的特征映射:

(1)

(2)

(3)

其中, 为输入特征图, 表示卷积矩阵。

为了提取特征图中不同位置之间得权重,使网络自适应的学习特征图中更重要的特征表示,我们引入了空间注意力模块。首先将特征图 和 进行元素加法,形成一个新的特征图,对融合后的特征图进行 卷积以及 激活,得到空间注意力权重图:

(4)

其中, 表示得到的空间注意力权重图, 表示 激活函数。然后对 进行重新采样,获得与 和 具有相同通道数量的空间注意图 ,最后, 分别与特征图 和 相乘,得到输出:

(5)

空间注意力机制得到的是特征图相对位置之间的权重,通道注意力是提高重要特征通道的权重,所以我们在得到空间注意力机制输出的特征图之后,对这些特征图进行通道注意力加权操作。具体来说,我们将经过 卷积之后的特征图 与空间注意力得到的特征图 进行融合,融合后的特征图分别进行平均池化和最大池化操作,然后经过共享的多层感知机,得到两组特征向量,将两组特征向量融合,经过 激活,就得到通道注意力机制下的权重向量:

(6)

(7)

其中, 和 分别表示全局平均池化和全局最大池化, 表示多层感知机。

最后我们将得到的通道权重向量 与特征图 相乘,经过 卷积改变通道数,得到最后的输出:

(8)

那么, 就是混合注意力模块(HAM)的输出特征图,我们将它作用在每次下采样的过程中。

首先,这个模块能够有效地捕捉乳腺超声图像的空间信息。通过空间注意力机制,模块能够自适应地强调图像中不同区域的特征,尤其是那些包含重要结构信息的区域,如乳腺肿块和纹理细节。这有助于提高分割任务的准确性,因为模块可以更好地聚焦在感兴趣的区域上,减少了背景噪声的干扰。其次,通道注意力部分使模块能够有效地捕捉不同通道之间的特征关系。这对于乳腺超声图像非常关键,因为不同通道可能包含不同的信息,如边缘信息、密度信息等。通过通道注意力,模块可以自适应地分配不同通道的重要性,确保在分割任务中更好地利用这些多源信息,提高了模型的综合性能。

3.3. 自适应深度监督技术

对于解码器部分,我们采样原始的上采样操作,每一个解码器模块使用两个 卷积将高分辨率图像恢复到原始分辨率。不同的是,我们在解码器部分加入了深度监督技术,以获得更直接、更具判别性的特征,使网络可以自适应的调整每一层解码器的输出的分割结果。具体来说,我们将每层解码器生成的特征图重新采样到一个通道,这时可以得到尺度不同的4类特征图,然后通过双线性插值操作将四类特征图恢复到同样的大小,得到4种不同分辨率的分割结果 ,使用混合损失函数计算四种分割结果与真实标签Y的损失,由最后一层解码器输出最终的预测结果。

每个解码器层都产生一个分割结果并与真实标签计算损失,这种多层次的监督有助于加速模型的收敛速度,减少梯度消失问题,从而提高训练的稳定性。此外,深度监督还有助于防止模型过拟合,因为即使早期的解码器层在训练过程中性能较差,它们仍然会受到损失函数的监督,有助于模型学习更好的特征表示。

我们采用了传统的二元交叉熵来计算每一层解码器得到的损失:

(9)

其中, 或 是像素点的真实标签, 表示像素点属于背景区域, 表示像素点属于病灶区域, 是像素点的分类概率。

整个网络使用的混合损失函数为:

(10)

其中, 为网络可学习的参数且 , 为第 层解码器输出的特征图的分割损失:

(11)

表示像素点的总数,B是批处理大小,C是特征通道数, 是特征图大小。

通过使用四层解码器分别输出不同尺度大小的分割图,可以捕捉到不同层次的图像细节信息。这意味着网络能够同时处理图像中的局部细微结构和整体特征,更好的融合不同分辨率下的特征图。通过使用自适应混合损失函数,将多个分割结果结合在一起,模型可以自适应地决定不同层次分割结果的权重,调整不同尺度大小的特征图的重要性。这种方法提高了模型的灵活性和适应性,因为不同图像和任务可能需要不同程度的多尺度信息,自适应性有助于模型在各种情况下获得最佳性能。

4. 结果

4.1. 数据集

我们在两个数据集上测试了我们的网络。其中BUSI (Breast Ultrasound Image)数据集是用于乳腺超声图像分割和分类任务的公开数据集之一 [12] 。它是由来自意大利比萨大学的研究人员创建的,收集了780张乳腺超声图像,其中良性肿块437例,恶性肿块210例。第二个数据集是来自浙江大学医学院的私有乳腺肿瘤数据集(BUS),为了获取真实标签,我们请经验丰富的放射科医生对数据集进行了注释,并最终选取了150张恶性乳腺肿瘤的超声图像来验证我们的网络。我们将两个数据集随机分为70%的训练集,20%的验证集,10%的测试集。

4.2. 实施细节

我们在PyTorch框架下训练我们提出的模型,所有实验均在运行Linux-5.4.0操作系统和Python 3.10环境的服务器上进行。该服务器采用代Intel® Xeon® Ice Lake处理器,配备了NVIDIA RTX A6000 GPU,为了加速GPU的计算性能,我们使用了NVIDIA CUDA 11.4版本。我们使用一个常见的分割损失函数二元交叉熵损失和一个学习率为 的Adam优化器来训练所有模型。批量大小和epoch的数量分别设置为16和500。在训练过程中,我们还应用了模拟退火策略来优化学习率。两个数据集上的所有实验都在相同的训练、验证和测试数据集上进行。

4.3. 评价指标

我们使用的评价指标是IoU和Dice系数。IoU (Intersection over Union)是一种用于评估目标检测、图像分割和其他计算机视觉任务性能的常见评价指标。IoU衡量预测结果与真实标注之间的重叠程度,它通过计算两个区域的交集面积与它们的并集面积之间的比率来衡量算法的准确性。

(12)

Table 1. Segmentation accuracy under different methods

表1. 不同方法下的分割精度

Figure 3. The variation curve of segmentation accuracy under different methods

图3. 不同方法下的分割精度变化曲线

Dice系数,也称为“F1 score”。该指标通常用于衡量两个集合的相似性,在图像分割、医学图像处理和自然语言处理等领域中广泛使用。

(13)

其中, 表示正确的阳性样本分类数, 表示正确的阴性样本分类数, 表示错误的阳性样本分类数, 表示错误的阴性样本分类数。

IoU和Dice的取值范围在0到1之间。当预测区域完全与真实标注区域重合时,结果为1,表示完美匹配。

4.4. 实验结果

在相同的实验环境下,我们将与U-Net、UNet++、Attention U-Net、TransUNet、CENet这5种比较经典的网络做了比较(见表1),来验证我们所提出的自适应混合注意力网络的性能和优势。可以看出,我们提出的网络在两个乳腺超声图像数据集上的分割精度都优于传统的方法。对于BUSI数据集,其良性肿瘤和恶性肿瘤分割的Dice系数分别达到了75%和72%,相较于经典的U-Net方法,提高了大约5个百分点;对于BUS数据集,恶性肿瘤分割的Dice系数达到了75%,相较于U-Net大约提高了7个百分点。

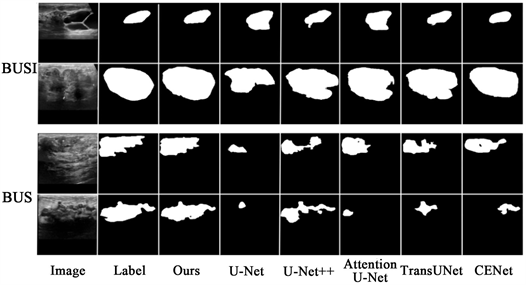

Figure 4. Segmentation visualization results by different methods

图4. 不同方法的分割可视化结果

为了验证我们所提出的网络的稳定性和有效性,我们提取出前300次迭代的分割结果绘制了折线图(见图3)。从Dice系数的变化来看,我们提出的网络不仅取得了最高的分割精度,而且最快趋于稳定,这也证明了我们的自适应混合注意力网络明显提高了乳腺超声图像的分割性能。

我们使用了一些具有不同质量大小、斑点噪声的乳腺超声图像对各种方法的分割结果进行视觉对比(见图4),展示了这些方法在BUSI和BUS数据集上分割的可视化结果。可以看出,我们提出的网络相较于其他方法能够更精准的定位分割目标,对于肿瘤的边缘细节信息和整体结构分割的更加准确。总之,混合注意力模块通过有效地结合空间和通道注意力,提高了乳腺超声图像下采样过程的性能,使模型提取病灶的信息更具准确性;自适应深度监督技术的使用有助于加速模型的收敛速度,减少梯度消失问题,从而提高训练的稳定性。

为了验证我们所提出的自适应混合损失函数的有效性,我们将所提出的方法与传统的损失函数进行对比,我们设计了两组对比实验。在第一组对比实验(C1)中,不使用自适应深度监督技术,仅在最后一层解码器输出预测结果并计算损失。在第二组对比实验(C2)中,我们直接为混合损失含函数的每一项赋予相同的权重。分别比较这两种损失函数与我们提出自适应混合损失含函数的分割精度,实验结果如下。

Table 2. Ablation experiments of hybrid loss function

表2. 混合损失函数消融实验

可以看出(见表2),我们提出的自适应混合损失函数可以有效的提高超声图像的分割精度,这是因为我们的混合损失函数包含了不同尺度特征图的分割信息,从而更好的提高网络对全局信息的捕获能力。

5. 结论

在本文中,我们在U-Net的基础上提出了一种新的自适应混合注意力网络,用于乳腺超声图像分割。在编码器部分,我们将原始的下采样操作替换为了混合注意力模块,它结合了空间注意力和通道注意力,能够更有效地捕捉乳腺超声图像的空间信息和通道特征,从而提高了下采样和分割任务的性能,有助于更准确地识别和分割乳腺图像中的结构,此外,混合注意力模块可以轻松嵌入到现有的深度学习架构中,提升模型的性能,同时也可以在不同任务和领域中广泛应用。在解码器部分,我们使用了自适应的深度监督技术,使不同尺度的分割结果进行融合,模型可以同时处理全局和局部信息,更好地理解图像的上下文。这种自适应的深度监督技术通过多尺度分割、深度监督和自适应性损失函数的组合,显著提高了分割模型的性能和鲁棒性,使其更适用于处理复杂的医学图像分割任务,同时提高了训练的效率和模型的泛化能力。

基金项目

这项工作得到了国家自然科学基金(批准号:61902192)和江苏省高水平创新创业项目(江苏省人事厅文:61902192)的支持。

文章引用

徐梦琪. 用于超声图像分割的自适应混合注意力算法

An Adaptive Hybrid Attention Algorithm for Ultrasonic Image Segmentation[J]. 运筹与模糊学, 2024, 14(01): 24-32. https://doi.org/10.12677/ORF.2024.141003

参考文献

- 1. Litjens, G., Kooi, T., Bejnordi, E., Setio, A., Ciompi, F. and Ghafoorian, M. (2017) A Survey on Deep Learning in Medical Image Analysis. Medical Image Analysis, 42, 60-88. https://doi.org/10.1016/j.media.2017.07.005

- 2. Ning, Z., Zhong, S., Feng, Q., et al. (2022) SMU-Net: Sali-ency-Guided Morphology-Aware U-Net for Breast Lesion Segmentation in Ultrasound Image. IEEE Transactions on Medical Imaging, 41, 476-490. https://doi.org/10.1109/TMI.2021.3116087

- 3. Ronneberger, O., Fischer, P. and Brox, T. (2015) U-Net: Convolutional Networks for Biomedical Image Segmentation. Medical Image Computing and Computer Assisted Intervention Society, Vol. 9351, Springer, Cham, 234-241. https://doi.org/10.1007/978-3-319-24574-4_28

- 4. Zhou, Z.M. Siddiquee, M.R., Tajbakhsh, N. and Liang, J. (2020) UNet++: Redesigning Skip Connections to Exploit Multiscale Features in Image Segmentation. IEEE Transactions on Medical Imaging, 39, 1856-1867. https://doi.org/10.1109/TMI.2019.2959609

- 5. Feng, J., Deng, J., Li, Z., et al. (2020) End-to-End Res-Unet Based Reconstruction Algorithm for Photoacoustic Imaging. Biomedical Optics Express, 11, 5321-5340. https://doi.org/10.1364/BOE.396598

- 6. Gao, H., Zeng, X., Pan, D. and Zheng, B. (2021) Covariance Self-Attention Dual Path UNet for Rectal Tumor Segmentation. 2021 IEEE International Conference on Robotics and Automation (ICRA), 30 May-5 June 2021, Xi’an, 11162-11168. https://doi.org/10.1109/ICRA48506.2021.9561826

- 7. Ning, Z., Zhong, S., Feng, Q., et al. (2022) SMU-Net: Saliency-Guided Morphology-Aware U-Net for Breast Lesion Segmentation in Ultrasound Image. IEEE Transactions on Medical Imaging, 41, 476-490. https://doi.org/10.1109/TMI.2021.3116087

- 8. Zhao, X., Zhang, P., et al. (2022) Prior Attention Network for Multi-Lesion Segmentation in Medical Images. IEEE Transaction on Mecical Imaging, 41, 3812-3823. https://doi.org/10.1109/TMI.2022.3197180

- 9. He, Q., Yang, Q., Xie, M., et al. (2023) HCTNet: A Hybrid CNN-Transformer Network for Breast Ultrasound Image Segmentation. Computersin in Biology and Medicine, 155, 106629. https://doi.org/10.1016/j.compbiomed.2023.106629

- 10. Oktay, O., Schlemper, J., Folgoc, L., Lee, M. and Heinrich, M. (2018) Attention U-Net: Learning Where to Look for the Pancreas. arXiv:1804.03999.

- 11. Hou, Y., et al. (2022) A U-Net Lung Nodule Image Segmentation Method Incorporating a Dual Attention Module. Computer Science and Application, 12, 1748-1756. https://doi.org/10.12677/CSA.2022.127177

- 12. Al-Dhabyani, W., Gomaa, M., Khaled, H. and Fahmy, A. (2020) Dataset of Breast Ultrasound Images. Data in Brief, 28, 104863. https://doi.org/10.1016/j.dib.2019.104863