Computer Science and Application

Vol.

11

No.

06

(

2021

), Article ID:

43119

,

10

pages

10.12677/CSA.2021.116171

基于多尺度顶帽变换的红外与可见光图像融合

王雪梅,陈立,汪君,王琴

湖北省市场监督管理局行政许可技术评审中心,湖北 武汉

收稿日期:2021年5月8日;录用日期:2021年6月5日;发布日期:2021年6月15日

摘要

针对传统多尺度图像融合方法容易弱化红外目标信息和降低图像对比度的问题,本文借助于形态学的优势和模糊规则的特性,提出一种简单、高效的红外与可见光图像融合算法。首先,使用多尺度形态学分离源图像高频成分和低频成分;其次,利用模糊规则整合低频成分,使用均值法合理注入图像高频成分;最后,经过形态学逆变换得到融合图像。实验结果表明,与传统融合方法相比,本文算法能够较好地保留可见光图像中的细节信息,突出红外目标信息。

关键词

图像融合,红外与可见光图像,形态学,模糊规则

Fusion of Infrared and Visible Images Based on Multi-Scale Top-Hat Method

Xuemei Wang, Li Chen, Jun Wang, Qin Wang

Administrative Licensing Technology Evaluation Center of Hubei Market Supervision Administration, Wuhan Hubei

Received: May 8th, 2021; accepted: Jun. 5th, 2021; published: Jun. 15th, 2021

ABSTRACT

Aiming at the problem that the traditional multi-scale image fusion method is easy to weaken the infrared target information and reduce the image contrast, this paper proposes a fusion algorithm of infrared and visible image by virtue of the advantages of morphology and the characteristics of fuzzy rules. Firstly, multi-scale morphology was used to separate high-frequency and low-frequency components from source images. Secondly, the fuzzy rules were used to integrate the low frequency components, and the mean value method was used to inject the high frequency components reasonably. Finally, the fused image is obtained by morphological inverse transformation. Experimental results show that, compared with the traditional fusion method, the proposed algorithm can retain the detailed information in visible image and highlight the infrared target information.

Keywords:Image Fusion, Infrared and Visible Images, Morphology, Fuzzy Logic

Copyright © 2021 by author(s) and Hans Publishers Inc.

This work is licensed under the Creative Commons Attribution International License (CC BY 4.0).

http://creativecommons.org/licenses/by/4.0/

1. 引言

由于成像模式不同,同一场景的红外图像和可见光图像具有很好的互补性,将这两类图像信息整合成一幅图像,不仅有利于场景视觉效果优化,还有利于各类图像处理,如目标跟踪、分类、分割等。伴随着信息技术迅猛发展,种类繁多的图像融合算法不断涌现。其中,多尺度分析法由于具有简单、高效的优点,基于多尺度的图像融合算法得到了长足的发展,如小波分析算法(WT) [1]、非下采样轮廓波算法(NSCT) [2]、曲率变换算法(CVT) [3]、双树复小波变换(DTCWT) [4] 等。然而,传统多尺度算法中所需的滤波器不具有自适应性,这会导致对于不同的融合对象,其融合性能会存在一定的差异,甚至会由于滤波器的非理想性,产生频率或尺度混叠现象,进而影响图像融合效果 [5] [6]。

数学形态学是一种数学逻辑严谨和算法简单的非线性分析方法,借助于特定结构元素可以捕捉图像中目标形状、边缘等细节特征,具有增强图像特征信息、提高图像对比度的能力 [1] [4]。红外图像通常细节信息模糊、目标与背景对比度较低、灰度范围较窄,因此,红外与可见光图像融合目标不仅要保留丰富的可见光图像细节信息,还要提高目标与背景的对比度,以利于人眼视觉和图像处理。综上可知,利用形态学算法整合红外和可见光图像信息具有较好的优势。

顶帽变换(Top-Hat Transform)是一种重要的形态学运算,它能有效地抽取图像特征区域,“捕获”图像细节信息。结合结构元素扩张的多尺度技术,顶帽变换已被在目标探测、图像融合和图像增强等领域成功的得到应用 [7] [8] [9]。然而,传统多尺度顶帽变换中的结构元素单一,在分析图像特征信息时容易遗漏或平滑图像细节信息,导致多图像整合效果不佳 [10]。为了避免内容丰富的图像特征区域或细节信息平滑,Bai X设计了一种新颖的结构元素,并提出中心环绕顶帽变换(Center-surround Top-hat Transform)算法,它能很好地捕获图像特征和细节信息,使融合图像特征区域和细节信息丰富,并能增强图像对比度 [7] [11]。然而,在这些算法中,作者主要关注新结构元素抽取信息的能力,忽略了不同尺度下信息的冗余关系,导致信息融合结果中仍存在细节信息平滑的问题。

高斯模糊逻辑能有效地区分红外图像的目标和背景信息,经过简单的隶属度标注不仅能压制红外背景信息,还能凸显目标信息 [12]。因此,可利用高斯模糊逻辑捕获红外目标特征,并将可见光细节信息移植到红外背景中,可以在融合图像中既保留红外目标特征,又可呈现可见光等细节信息。

为解决现有形态学融合算法中存在的不足,本文基于中心环绕顶帽变换的信息捕获能力和高斯模糊逻辑的特点,提出一种适于红外和可见光图像的融合算法。实验结果表明本文提出方法的融合结果能较好地保留原图像的细节信息,凸显红外目标特征。

2. 形态学

数学形态学在图像处理领域具有重要的应用价值。结合结构元素的多尺度膨胀,形态学序列运算可以构造各类型的多尺度形态学操作。

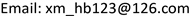

1) 中心环绕结构元素

由于传统形态学结构元素结构单一,因此对图像特征区域的差异性不敏感,存在捕获图像细节信息失效的问题。为提升形态学操作分析图像信息的能力,Bai X [7] [11] 使用两个同形状但尺寸相近的结构元素构建中心环绕结构元素,如图1所示的圆盘中心环绕结构元素,其中,外部结构元素Bo尺寸大于内部结构元素Bin尺寸。

Figure 1. Center-surround disk structural element [7]

图1. 圆盘中心环绕结构元素 [7]

中心环绕结构的有效区域可定义为边界结构元素可定义为:

(2-1)

当ΔB区域小于特征区域时,环绕区域边界可以有效地捕获图像特征信息,并且根据不同需求,该结构通过尺度伸缩可以识别不同尺度的图像信息。根据不同的应用需求,可利用不同形状的结构元构建中心环绕结构元素,本文选取“圆盘”中心环绕结构为基本结构元素。

2) 结构元素多尺度扩展

图像通常包含丰富的尺度特征区域和细节,用单一尺度结构元素仅能抽取与其尺度对应的图像特征,不能有效地分析包含丰富特征信息的图像。为了有效地分析图像中的各种特征信息,多尺度形态学应运而生。形态学多尺度扩展是通过循序渐进地膨胀结构元素完成尺度扩展,使结构元素能在不同尺度下捕获图像特征信息。

以图1圆盘中心环绕结构元素为例,假设L和W分别是初始结构元素Bb和ΔB的尺寸,ΔB中的边界宽度为M,中心环绕结构元素扩展n次,每次扩展的步长为Step,于是中心环绕结构元素在尺度s (1 < s ≤ n)的尺寸可以表示为:

(2-2)

为了区分不同尺度下的中心环绕结构元素,在尺度s下的双结构元素分别表示为ΔBs和Bbs,即,Bbs的尺寸为Ls,ΔBs的边界尺度为Ws,边界宽度仍为M。经过多尺度扩展后,中心环绕结构元素就能抽取不同尺度下的特征区域及其特征环绕区域。

3) 顶帽变换

假设图像使用f (x, y)表示,基于中心环绕结构元素的开、闭运算使用f£Boi和f■Boi表示为:

(2-3)

(2-4)

Boi表示一组中心环绕双结构元素,它由Bo和Bin两个相关的结构元素组成。由于使用了双结构元素,开(闭)运算能更好地平滑图像的亮(暗)区域特征,包括亮(暗)特征区域的环绕区域。则白顶帽变换(NWTH)和暗顶帽变换(NBTH)可表示为:

(2-5)

(2-6)

开运算能从图像中移去小于结构元素尺寸的亮特征,这就使得它能平滑图像的亮区域,因此白顶帽(NWTH)能用来抽取图像的亮特征区域。相反,闭运算从图像中移去小于结构元素尺寸的暗特征,这就使得它能平滑图像的暗图像区域,因此暗顶帽(NBTH)能用来抽取图像的暗特征区域。也就是说,一次顶帽变换能将图像拆分成一个基图像和两个表征亮、暗特征区域的图像。顶帽变换的性能对图像特征的尺寸很敏感,当使用不同尺寸的结构元素时,顶帽变换就会抽取图像中不同大小的亮、暗特征区域 [6]。

3. 基于多尺度顶帽变换的图像融合方法

顶帽变换对图像特征区域的尺寸大小极为敏感,结合多尺度中心环绕结构元素的信息捕获能力,本文提出一种新的红外与可见光图像融合方法。

3.1. 图像特征信息抽取

假设k幅源图像分别记为f1,……,fj,……,fk,(1 ≤ j ≤ k)。为抽取图像不同尺度的亮、暗特征区域,对中心环绕结构元素进行多尺度扩展,则多源图像在不同尺度下的顶帽变换可表示为 [6]:

(3-1)

(3-2)

上式中的标号j表示第j幅源图像,标号s表示在第s尺度下进行顶帽变换,Boi,s表示尺度s处的中心环绕结构元素。随着结构元素尺寸的增大,使用大尺寸结构元素抽取的特征区域会包含很多在小尺寸下抽取的特征区域。这就造成不同尺度下抽取的特征信息彼此会包含大量冗余信息,进而影响最后的融合结果。为了避免这一问题,并更好地表征图像特征,本文使用下面的方法对抽取的亮、暗特征区域进行精炼提取,以减小不同尺度层之间的信息冗余,并更好地表征特定尺度下的特征区域信息。

(3-3)

(3-4)

上式中, 抽取的是图像fj从尺度1到尺度s的亮特征区域,而 抽取的是图像fj从尺度1到尺度s + 1的亮特征区域,通过式(3-3),尺度s + 1下的亮特征区域信息就很好地在 中得到了表征,且 不包含其他尺度的信息。类似地, 能很好地表征尺度s + 1下的暗特征区域信息。

3.2. 图像融合方法

本文使用恰当方式整合亮、暗特征信息,并得到融合图像。

3.2.1. 图像特征区域融合

本节对抽取的尺度区域特征进行归一化处理,以消除区域特征图像中可能出现的负值,获取更精确的亮、暗特征图像,有效地抽取每一尺度下的图像区域和感兴趣细节,并减小不同尺度层之间的冗余信息。

(3-5)

(3-6)

对不同源图像的同层特征区域信息进行以下操作得到相应的融合特征信息。

(3-7)

(3-8)

因为不同尺度层的特征和细节彼此不相同,因此,可以将各尺度层的特征区域信息进行如下整合,得到融合的亮、特征区域图像

(3-9)

(3-10)

WF和BF分别表示最后的融合亮、暗特征区域。

3.2.2. 获取基图像

WF和BF主要表征的是多源图像的特征和细节信息,为了获取最后的融合图像,需要获得一幅包含多源图像主要能量信息的基图像。不同于传统的多尺度变换能将图像分解的剩余成分作为图像的低频信息,基于形态学的运算一般只能利用其自身的特性抽取图像的各种特征信息,而不能预留对应的低频信息。本文在尺度扩展过程中利用最大尺度的外结构元素获取的平滑图像表示图像的低频信息。

(3-11)

(3-12)

在式(3-11)和(3-12)中,Bbn表示结构元素扩展时,最大尺度中心环绕结构元素的外结构元素,Oj和Cj分别代表第j幅源图像的平滑亮、暗图像信息。为了获得融合的平滑亮图像信息,本节使用高斯模糊逻辑法将不同源图像的Oj进行整合,得到融合的亮平滑图像O。使用同样的方法获得融合的暗平滑图像C,最后,使用均值法获取O和C的融合图像。下面是基于高斯模糊逻辑自适应地整合亮图像信息。

(3-13)

式(3-13)中的下标IR,VI和F分别代表红外,可见光和融合图像。O (i, j)是亮图像信息。ηT和ηB分别是红外信息中目标和背景的隶属度(权值)。

根据红外低频成分直方图的特性,高斯隶属度函数能很好地描述红外图像的目标和背景信息 [12]。在文献中 [12],作者获得了很好的融合结果,本文使用高斯函数确定信息整合的隶属度权值。

(3-14)

(3-15)

式(3-14)中的μ和σ分别是红外信息的均值和方差。k是一个用于优化融合结果的常数,其取值范围为1~3。在我们的试验中,k值均设置为1.5。

3.2.3. 图像信息融合

分别获取了基图像和融合的亮、暗特征区域图像后,为了得到较好的融合结果,需要使用恰当的方式将亮、暗特征图像注入到基图像。实验结果表明,均值权重法能根据亮、暗特征图像的特性自适应地向基图像中注入有用的特征信息,并获得较好的融合结果 [6]。本节采用均值权重法整合特征区域图像和基图像的信息。

(3-16)

(3-17)

式中,mw和mb分别为WF和BF在3× 3窗口尺寸下的均值,A表示基图像,fu表示最后的融合图像。

4. 实验与分析

为了验证提出基于多尺度顶帽变换的红外与可见光图像融合算法可行性和有效性,本文针对4组红外与可见光图像 [6] [10] [11],选取3种常用的性能较优多尺度融合算法DTCWT [4],NSCT [2] 和CVT [3] 与本文算法进行比较。使用信息熵、标准差、空间频率和平均梯度 [6] 4种客观指标对融合结果进行评价。

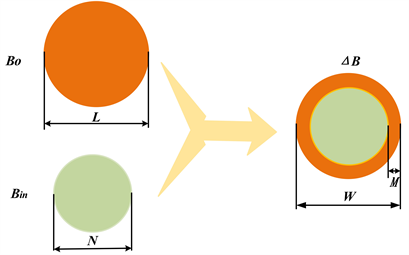

由各组融合结果可知,传统的多尺度融合算法的性能比较相近,这些算法普遍损失了部分源图像的细节信息,导致融合结果趋于平滑,图像层次感较差,特别是在显著的目标区域边缘出现“振铃”、光晕、抖动等现象,导致图像对比度下降,目标和细节模糊,整体视觉效果不佳。从主观的视觉效果分析,本文算法的融合结果细节信息丰富,红外目标信息显著,目标边缘信息清晰,图像对比度更优,融合图像清晰自然(图2~5)

Figure 2. The first fusion result comparison of infrared polarization and intensity image

图2. 第1组可见光与红外图像融合结果对比

Figure 3. The second fusion result comparison of infrared polarization and intensity image

图3. 第2组可见光与红外图像融合结果对比

Figure 4. The third fusion result comparison of infrared polarization and intensity image

图4. 第3组可见光与红外图像融合结果对比

Figure 5. The four fusion result comparison of infrared polarization and intensity image

图5. 第4组可见光与红外图像融合结果对比

为了进一步验证本文算法的有效性,使用熵、平均梯度、空间频率和标准差4类图像质量指标对各算法融合结果进行客观评价,这些指标的值越大,表明图像融合效果越好。由表1~4的数据可知,本文算法的平均梯度、空间频率和标准差明显优于其他参考算法,说明本文算法具有更优的对比度和清晰度,图像层次分明。尽管本文算法的图像信息熵不总是最优,但从各表中数据可知,本文算法的熵值是较优的,表明图像具有丰富的信息。

Table 1. Objective value comparison of the first fusion experiment

表1. 第1组融合实验客观评价值比较

Table 2. Objective value comparison of the second fusion experiment

表2. 第2组融合实验客观评价值比较

Table 3. Objective value comparison of the third fusion experiment

表3. 第3组融合实验客观评价值比较

Table 4. Objective value comparison of the four fusion experiment

表4. 第4组融合实验客观评价值比较

5. 结论

本文针对传统多尺度图像融合方法容易弱化红外目标信息和降低图像对比度的问题,基于新颖的形态学结构元素和高斯模糊逻辑,提出一种简单、高效的红外与可见光图像融合算法。实验结果表明,本文提出的方法使融合结果拥有丰富的细节信息、显著的目标信息、更高的清晰度和对比度,其性能优于传统的多尺度融合方法。

文章引用

王雪梅,陈 立,汪 君,王 琴. 基于多尺度顶帽变换的红外与可见光图像融合

Fusion of Infrared and Visible Images Based on Multi-Scale Top-Hat Method[J]. 计算机科学与应用, 2021, 11(06): 1662-1671. https://doi.org/10.12677/CSA.2021.116171

参考文献

- 1. 张雨晨, 李江勇. 基于小波变换的中波红外偏振图像融合[J]. 激光与红外, 2020, 50(5): 578-582.

- 2. 颜正恕, 王璟. 基于非下采样轮廓波变换耦合对比度特征的遥感图像融合算法[J]. 电子测量与仪器学报, 2020, 34(3): 28-35.

- 3. 蒋婷婷, 周洁静. 基于改进Curvelet变换的图像融合算法研究[J]. 信息化研究, 2020, 3(45): 23-27.

- 4. 王亚杰, 李殿起, 徐心和. 基于双树复小波变换的夜视图像融合[J]. 系统仿真学报, 2008, 20(10): 2757-2761.

- 5. Li, S., Yang, B. and Hu, J. (2011) Performance Comparison of Different Multi-Resolution Transforms for Image Fusion. Information Fusion, 12, 74-84. https://doi.org/10.1016/j.inffus.2010.03.002

- 6. Zhu, P., Ma, X. and Huang, Z. (2017) Fusion of Infrared-Visible Images Using Improved Multi-Scale Top-Hat Transform and Suitable Fusion Rules. Infrared Physics & Technology, 81, 282-295. https://doi.org/10.1016/j.infrared.2017.01.013

- 7. Bai, X.Z., Zhou, F.G. and Xue, B.D. (2011) Infrared Image Enhancement through Contrast Enhancement by Using Multiscale New Top-Hat Transform. Infrared Physics & Tech-nology, 54, 61-69. https://doi.org/10.1016/j.infrared.2010.12.001

- 8. Li, Y., Yong, B., Wu, H., et al. (2014) An Improved Top-Hat Filter with Sloped Brim for Extracting Ground Points from Airborne Lidar Point Clouds. Remote Sensing, 6, 12885-12908. https://doi.org/10.3390/rs61212885

- 9. Tan, X., Chen, M. and Jiang, C. (2008) The Small Target detection Base on Wavelet Transform and Mathematical Morphology. Electronics Optics & Control, 9, 25-28.

- 10. Li, Y., Feng, X. and Xu, M. (2012) Infrared and Visible Image Features Enhancement and Fusion Using Multi-Scale Top-Hat Decomposition, Infrared and Laser Engineering. Infrared and Laser Engineering, 41, 2824-2832.

- 11. Bai, X.Z., Zhou, F.G. and Xue, B.D. (2011) Fusion of Infrared and Visual Images through Region Extraction by Using Multi Scale Center-Surround Top-Hat Transform. Optics Express, 19, 8444-8457. https://doi.org/10.1364/OE.19.008444

- 12. Yin, S.F., Cao, L.C., Tan, Q.F., et al. (2010) Infrared and Visible Im-age Fusion Based on NSCT and Fuzzy Logic. IEEE International Conference on Mechatronics and Automation (ICMA), Xi’an, 4-7 August 2010, 671-675. https://doi.org/10.1109/ICMA.2010.5588318