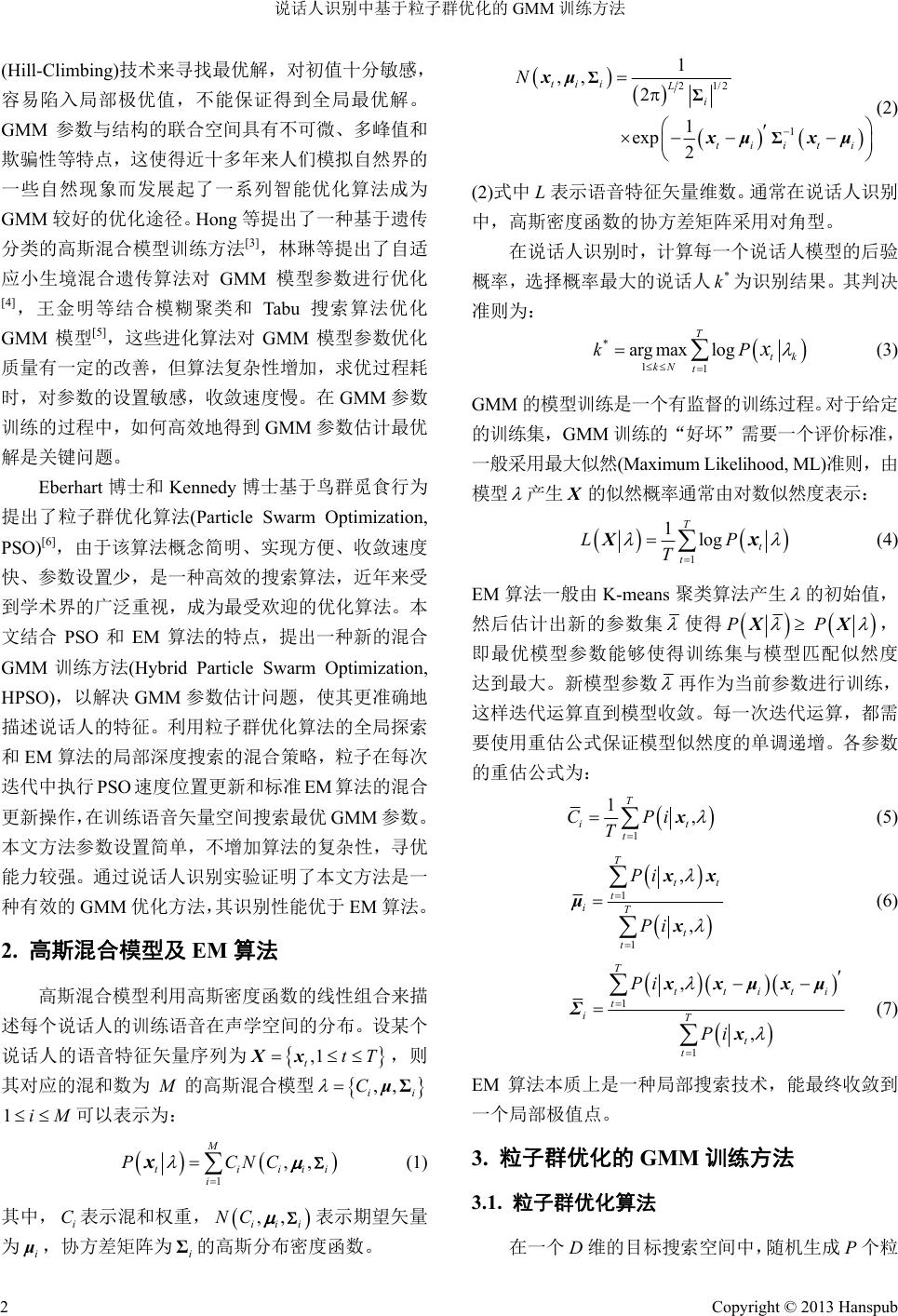

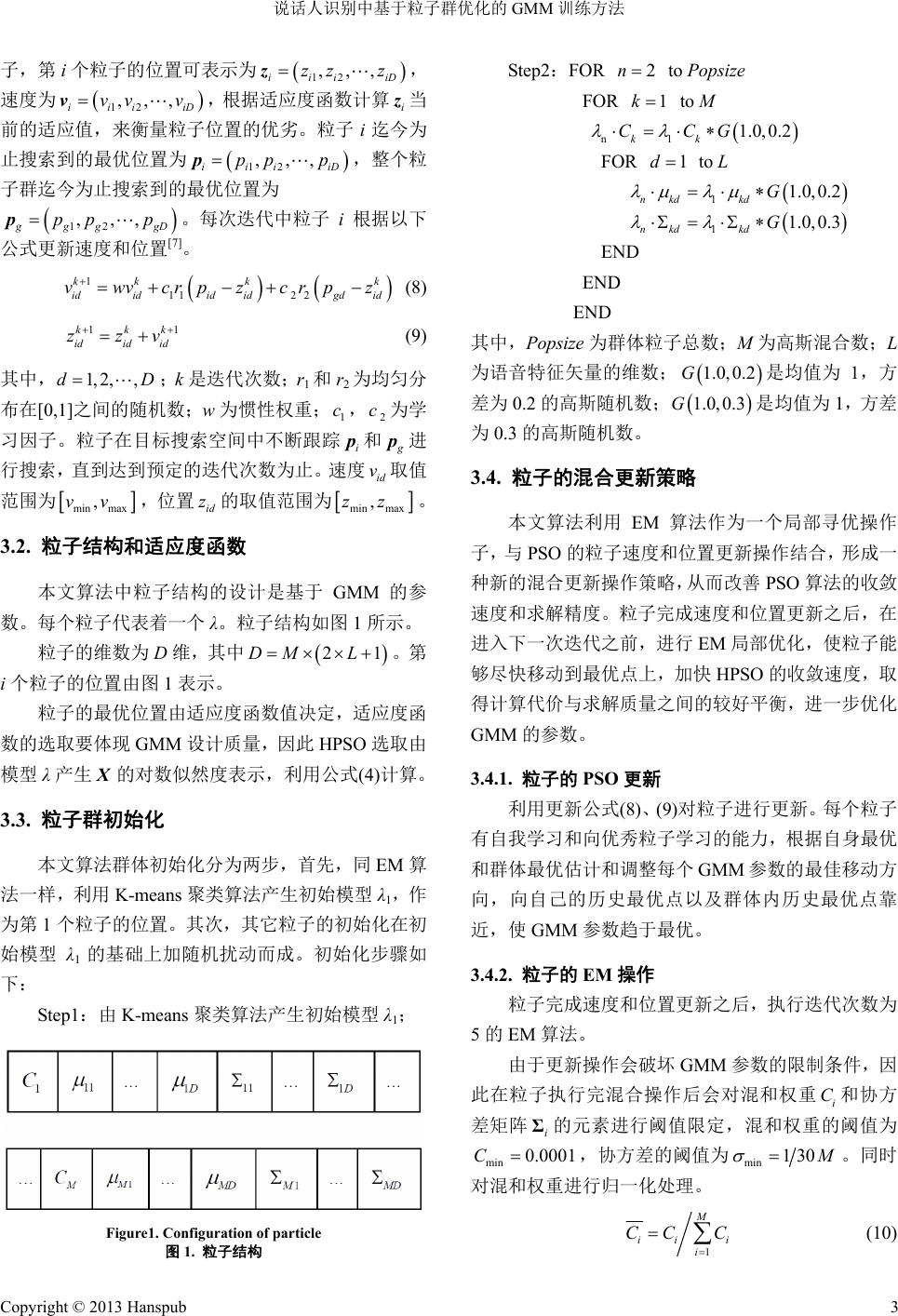

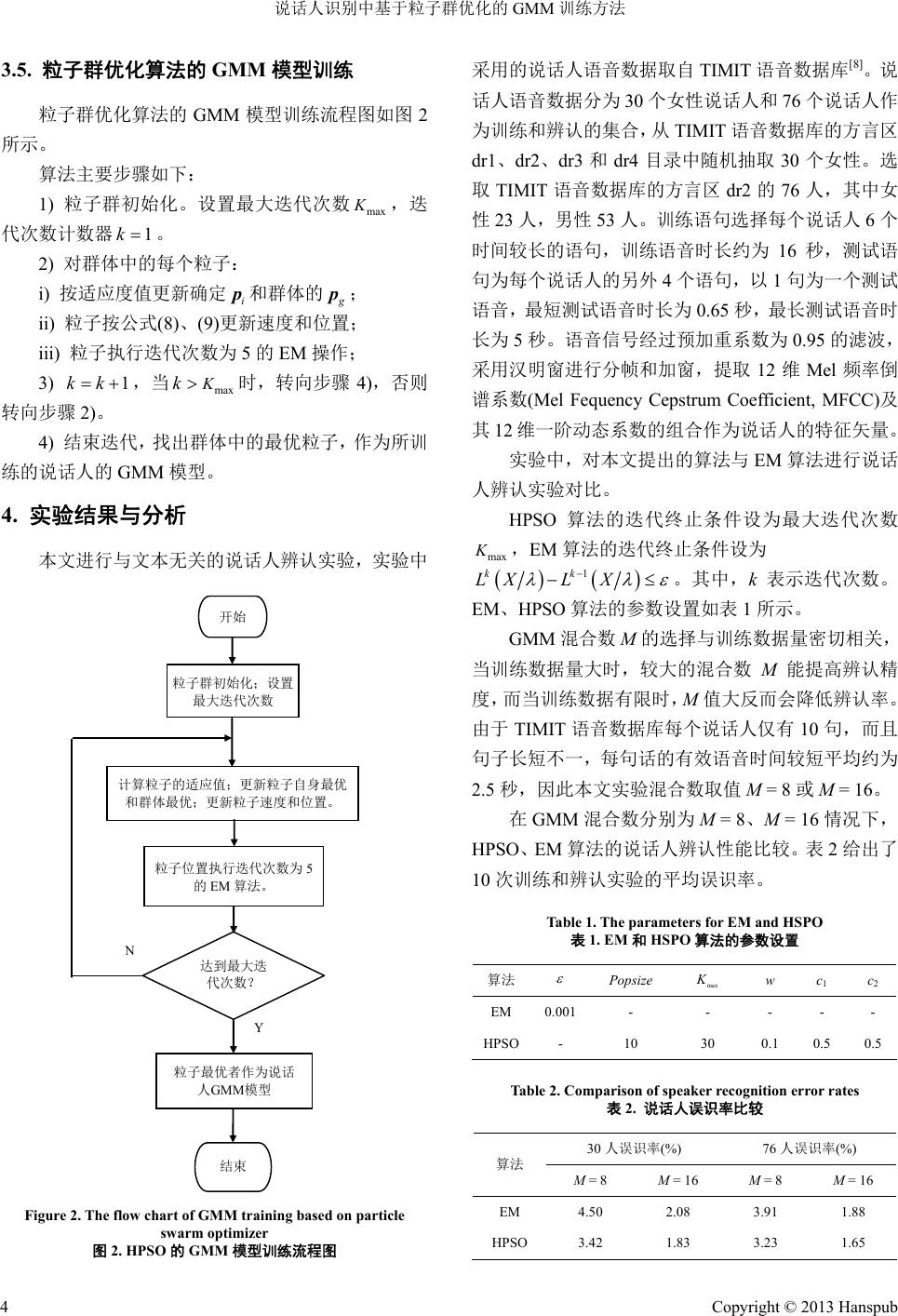

Software Engineering and Applications 软件工程与应用, 2013, 2, 1-5 http://dx.doi.org/10.12677/sea.2013.21001 Published Online February 2013 (http://www.hanspub.org/journal/sea.html) Gaussian Mixture Model Training Method Based on Particle Swarm Optimizer for Speaker Recognition* Liping Xue, Yinglong Yao, Zhiqiang Wang, Hong Zhou College of Computer Science and Software Engineering, Shenzhen University, Shenzhen Email: xuelp@szu.edu.cn Received: Nov. 14th, 2012; revised: Nov. 30th, 2012; accepted: Dec. 7th, 2012 Abstract: Expectation-Maximization (EM) algorithm is usually used to estimate parameters of Gaussian mixture model. Due to the hill-climbing ch aracteristic of EM, any arbitrary estimation of the initial model parameters will usually lead to a sub-optimal model in practice. To resolve this problem, a hybrid training method based on Particle Swarm Optimi- zation (PSO) is proposed. It utilizes the glob al searching capability of PSO and co mbines the effectiveness of EM. The particles perform basic operations of PSO (velocity updating and position updating) and EM algorithm, which can ex- plore the training speech space to move toward the global optimum. The dependence of the final model parameters on the selection of the initial model parameters is also reduced. Experimental results have showed that this method can obtain more optimized GMM parameters and has better capability than EM in speaker recognition. Keywords: Speaker Recognition; Particle Swarm Optimization (PSO); Gaussian Mixture Model (GMM) 说话人识别中基于粒子群优化的 GMM训练方法* 薛丽萍,姚应龙,王志强,周 虹 深圳大学计算机与软件学院,深圳 Email: xuelp@szu.edu.cn 收稿日期:2012 年11 月14 日;修回日期:2012 年11 月30 日;录用日期:2012 年12 月7日 摘 要:针对高斯混合模型(Gaussian Mixture Model, GMM)参数最优估计问题,常用的最大期望(Expectation- Maximization, EM)算法对初值敏感,在实际训练中极易得到局部最优参数,本文提出了一种 GMM 参数优化的 新方法。将 EM 算法融入到粒子群优化(Particle Swarm Optimization, PSO)训练过程,形成了一种新的混合算法, 利用 PSO 的全局探索和 EM 算法的局部深度搜索的混合策略,粒子在每次迭代中执行 PSO 速度位置更新和标准 EM 算法的混合更新操作,在训练语音矢量空间搜索最优高斯混合模型参数。从而避免传统 EM 算法陷入局部 最优的缺点。说话人辨认实验表明,与 EM 算法相比,本文方法可以得到更优的模型参数,能有效提高系统的 识别率。 关键词:说话人识别;高斯混合模型;粒子群优化 1. 引言 高斯混合模型(Gaussian Mixture Model, GMM)是 近年来应用最广泛的说话人统计模型[1,2],利用高斯密 度函数的线性组合来表示每个说话人的训练语音在 声学空间的分布,其模型的参数的估计一般利用最大 期望(Expectation-Maximization, EM)算法[2]。EM 算法 采用了最大似然为训练准则,具有很好的收敛性,然 而EM 算法是一种局部搜索算法,本质上采用爬山 *资助信息:深圳大学科学研究基金(200637)资助课题。 Copyright © 2013 Hanspub 1  说话人识别中基于粒子群优化的 GMM 训练方法 (Hill-Climbing)技术来寻找最优解,对初值十分敏感, 容易陷入局部极优值,不能保证得到全局最优解。 GMM 参数与结构的联合空间具有不可微、多峰值和 欺骗性等特点,这使得近十多年来人们模拟自然界的 一些自然现象而发展起了一系列智能优化算法成为 GMM 较好的优化途径。Hong 等提出了一种基于遗传 分类的高斯混合模型训练方法[3],林琳等提出了自适 应小生境混合遗传算法对 GMM 模型参数进行优化 [4],王金明等结合模糊聚类和 Tabu 搜索算法优化 GMM 模型[5],这些进化算法对GMM 模型参数优化 质量有一定的改善,但算法复杂性增加,求优过程耗 时,对参数的设置敏感,收敛速度慢。在 GMM参数 训练的过程中,如何高效地得到 GMM参数估计最优 解是关键问题。 Eberhart 博士和 Kennedy 博士基于鸟群觅食行为 提出了粒子群优化算法(Particle Swarm Optimization, PSO)[6],由于该算法概念简明、实现方便、收敛速度 快、参数设置少,是一种高效的搜索算法,近年来受 到学术界的广泛重视,成为最受欢迎的优化算法。本 文结合 PSO 和EM 算法的特点,提出一种新的混合 GMM训练方法(Hybrid Particle Swarm Optimization, HPSO),以解决 GMM 参数估计问题,使其更准确地 描述说话人的特征。利用粒子群优化算法的全局探索 和EM 算法的局部深度搜索的混合策略,粒子在每次 迭代中执行 PSO速度位置更新和标准 EM算法的混合 更新操作,在训练语音矢量空间搜索最优 GMM参数。 本文方法参数设置简单,不增加算法的复杂性,寻优 能力较强。通过说话人识别实验证明了本文方法是一 种有效的 GMM 优化方法,其识别性能优于 EM 算法。 2. 高斯混合模型及 EM 算法 高斯混合模型利用高斯密度函数的线性组合来描 述每个说话人的训练语音在声学空间的分布。设某个 说话人的语音特征矢量序列为 ,则 其对应的混和数为 M的高斯混合模型 可以表示为: ,1 ttTXx ,,C μ ii Σ 1iM 1 ,, M tiii i PCNC x i (1) 其中, 表示混和权重, i C ,, iii NC 表示期望矢量 为i μ ,协方差矩阵为 的高斯分布密度函数。 i Σ 1/2 2 1 1 ,, 2 1 exp 2 tii L i tiiti N Σ Σ Σ xμ xμx μ (2) (2)式中L表示语音特征矢量维数。通常在说话人识别 中,高斯密度函数的协方差矩阵采用对角型。 在说话人识别时,计算每一个说话人模型的后验 概率,选择概率最大的说话人 为识别结果。其判决 准则为: * k * 11 argmax log T tk kN t kPx (3) GMM 的模型训练是一个有监督的训练过 程。对于给定 的训练集,GMM 训练的“好坏”需要一个评价标 准, 一般采用最大似然(Maximum Likelihood, ML)准则,由 模型 产生 X 的似然概率通常由对数似然度表 示: 1 1log T t t LP T Xx (4) EM 算法一般由 K-means聚类算法产生 的初始值, 然后估计出新的参数集 使得 PP XX, 即最优模型参数能够使得训练集与模型匹配似然度 达到最大。新模型参数 再作为当前参数进行训练, 这样迭代运算直到模型收敛。每一次迭代运算,都需 要使用重估公式保证模型似然度的单调递增。各参数 的重估公式为: 1 1, T i t CPi T t x (5) 1 1 , , T tt t iT t t Pi Pi xx μ x (6) 1 1 , , T ttiti t iT t t Pi Pi xxμx μ Σ x (7) EM 算法本质上是一种局部搜索技术,能最终收敛到 一个局部极值点。 3. 粒子群优化的 GMM 训练方法 3.1. 粒子群优化算法 在一个 D维的目标搜索空间中,随机生成 P个粒 Copyright © 2013 Hanspub 2  说话人识别中基于粒子群优化的 GMM 训练方法 子,第 i个粒子的位置可表示为 12 ,,, iii iD zz zz, 速度为 12 ,,, iii iD vv vv,根据适应度函数计算 i z 当 前的适应置的优劣。粒子i迄今为 止搜索到的最优位置为 值,来衡量粒子位 12 ,,, iii iD pp pp,整个粒 子群迄今为止搜索到的最优 12 ,,, 位置为 g gg gD pp pp。每次迭代中 ]。 1kk vwvcp 粒子 i根据以下 公式更新速度和位置 k (8) (9) 其中, D;k [7 11 2 2 k ididid idgd id r zcrpz 11kkk idid id zzv 1, 2,,d ]之间的随机 是迭代次数; r1和r2为均匀分 布在[0,1 数;w为惯性权重; 1 c,2 c为学 习因子。粒子在目标搜索空间中不断跟踪 i p和 g p进 行搜索,直到达到预定的迭代次数为止。速度 id v值 范围为 取 min max ,vv ,位置 id z的取值范围为 min max zz 。 3.2. 粒子结构和适应度函数 , 本文算法中 GMM 的参 数。 i个粒 函数值决定,适应度函 数的 粒子结构的设计是基于 每个粒子代表着一个 λ。粒子结构如图 1所示。 粒子的维数为 D维,其中 21DM L。第 子的位置由图 1表示。 粒子的最优位置由适应度 选取要体现 GMM设计质量,因此 HPSO 选取由 模型 λ产生 X 的对数似然度表示,利用公式(4)计算。 3.3. 粒子群初始化 本文算法群体初始化分为两步,首先,同 EM算 法一 tep1:由 K-means 聚类算法产生初始模型 λ1; 样,利用 K-means 聚类算法产生初始模型 λ1,作 为第 1个粒子的位置。其次,其它粒子的初始化在初 始模型λ1的基础上加随机扰动而成。初始化步骤如 下: S OR 2n Figure1. Configuration of particle 图1. 粒子结构 Step2:F to Popsize FOR 1k to M 1.0,0.2 kk n1 CCG 1d FOR to L END EN E 其中,Popsi 体粒子总数;M为高斯混合数;L 略 作为一个局部寻优操作 子, O更新 )对粒子进行更新。每个粒子 有自 更新之后,执行迭代次数为 5的 会破坏 GMM 参数的限制条件,因 此在 1.0,0.2 kd kd G 1n 11.0,0.3 nkd kd G D ND ze 为群 为语音特征矢量的维数; 1.0,0.2G是均值为 1,方 差为 0.2 的高斯随机数;G均值为 1,方 差 为0.3 的高斯随机数。 3.4. 粒子的混合更新策 1.0,0.3 是 本文算法利用 EM 算法 与PSO 的粒子速度和位置更新操作结合,形成一 种新的混合更新操作策略,从而改善 PSO 算法的收敛 速度和求解精度。粒子完成速度和位置更新之后,在 进入下一次迭代之前,进行 EM 局部优化,使粒子能 够尽快移动到最优点上,加快 HPSO 的收敛速度,取 得计算代价与求解质量之间的较好平衡,进一步优化 GMM 的参数。 3.4.1. 粒子的 PS 利用更新公式(8)、(9 我学习和向优秀粒子学习的能力,根据自身最优 和群体最优估计和调整每个GMM参数的最佳移动方 向,向自己的历史最优点以及群体内历史最优点靠 近,使 GMM 参数趋于最优。 3.4.2. 粒子的 EM 操作 粒子完成速度和位置 EM 算法。 由于更新操作 粒子执行完混合操作后会对混和权重 i C和协方 差矩阵 i Σ的元素进行阈值限定,混和权重阈值为 min 0 01C 的 .00 ,协方差的阈值为 min 130 M 。同时 行归一化处理。 对混和权重进 1 M CC C ii i i (10) Copyright © 2013 Hanspub 3  说话人识别中基于粒子群优化的 GMM 训练方法 3.5. 粒子群优化算法的 GMM 如图 2 所示。 初始化。设置最大迭代次数 ,迭 代次 度新确定 和群体的 模型训练 粒子群优化算法的 GMM 模型训练流程图 算法主要步骤如下: 1) 粒子群 max K 数计数器 1k。 2) 对群体中的每个粒子: i) 按适应值更i p g p; 度和位置; 5作 转向 结束迭代 群体中 M模型。 的说话人辨认实验,实验中 ii) 粒子按公式(8)、(9)更新速 iii) 粒子执行迭代次数为的EM 操 ; 3) 1kk ,当 max Kk时,转向步骤 4),否则 步骤 2)。 4) ,找出 的最优粒子,作为所训 练的说话人的 GM 4. 实验结果与分析 本文进行与文本无关 Y 粒子位置执行迭代次数为 5 的EM 算法。 粒子群初始化; 设置 最大迭代次数 计算粒子的适应值;更新粒子自身最优 和群体最优;更新粒子速度和位置。 达到最大迭 代次数? 粒子最优者作为说话 人GMM模型 开始 N 结束 Figure 2. The flow chart of GMM training based on particle swarm optimizer 图2. HPSO的GMM 模型训练流程图 采 话人语音数据 说话人作 代终止条件设为 用的说话人语音数据取自 TIMIT 语音数据库[8]。说 分为 30个女性说话人和76 个 为训练和辨认的集合,从TIMIT 语音数据库的方言区 dr1、dr2、dr3 和dr4 目录中随机抽取 30 个女性。选 取TIMIT语音数据库的方言区dr2 的76 人,其中女 性23 人,男性53 人。训练语句选择每个说话人 6个 时间较长的语句,训练语音时长约为16 秒,测试语 句为每个说话人的另外 4个语句,以 1句为一个测试 语音,最短测试语音时长为 0.65 秒,最长测试语音时 长为 5秒。语音信号经过预加重系数为 0.95 的滤波, 采用汉明窗进行分帧和加窗,提取12维Mel频率倒 谱系数(Mel Fequency Cepstrum Coefficient, MFCC)及 其12 维一阶动态系数的组合作为说话人的特征矢量。 实验中,对本文提出的算法与 EM 算法进行说话 人辨认实验对比。 HPSO 算法的迭代终止条件设为最大迭代次数 K,EM 算法的迭 max 1k XL X k L 。其中,k表示迭代次数。 HPSO 算法的参数设置如表 1所 择与训练数据量密切相关, 当训练数据量大时,较大的混合数 M能提 EM、 示。 GMM 混合数 M的选 高辨认精 度, 10 次训 PO 置 算法 而当训练数据有限时, M值大反而会降低辨认率。 由于 TIMIT 语音数据库每个说话人仅有10句,而且 句子长短不一,每句话的有效语音时间较短平均约为 2.5 秒,因此本文实验混合数取值 M = 8或M = 16。 在GMM 混合数分别为 M = 8、M = 16情况下, HPSO、EM 算法的说话人辨认性能比较。表 2给出了 练和辨认实验的平均误识率。 Table 1. The parameters for EM and HS 表1. EM和HSPO 算 法的参数设 Popsize K w c1 c 2 max EM 0.001 - - - - - H- 10 30PSO 0.1 0.5 0.5 ble 2omparison of speakcogn errtes 表说话人误识率比较 Ta. Cer reition or ra 2. 30 人误识率(%) 76人误识率(%) 算法 M = 8 M = 16 M = 8 M = 16 EM 4. 3 50 2.08.91 1.88 HPSO 3.42 1.83 3.23 1.65 Copyright © 2013 Hanspub 4  说话人识别中基于粒子群优化的 GMM 训练方法 Copyright © 2013 Hanspub 5 05 101520 25 30 -44.8 -44.6 -44.4 -44.2 -44 -43.8 迭代次数 适应度值 HP SO EM Figure 3. Comparison of converging procedure of the two algo- rithms 图3. 两种算法的收敛特性比较 从表 2可以看出,辨 人时,HPSO 算法的误 率都低于 EM ,辨认集为同一方言区且人数增 加到 训练 快,随着粒子位置与群体最优解的差值 会逐 本文提出了一种新的 GMM 训练方法应用于说话 人识 参考文献 (References) obust text-independent speaker 别,利用 EM 算法作为一个局部寻优操作子,与 PSO 的粒子速度和位置更新操作结合,形成一种新的 混合更新操作策略,对 GMM 参数进行优化。算法采 用群体规模较小的 10个粒子,分别在目标搜索空间 中的进行全局探索和局部精细搜索,从而较好地平衡 全局优化和局部搜索,使得算法能够跳出局部最优。 使用 TIMIT 语音数据库,进行了与文本无关的说话人 辨认实验。取混合数分别为 M = 8、M = 16,比较了 EM 算法和本文算法的系统误识率,验证了混合更新 策略可以提高系统的辨认性能。同时从收敛过程进一 步证明了本文算法的有效性。实验结果表明新算法在 与文本无关的说话人辨认性能方面优于 EM 算法,算 法没有增加算法的复杂性,参数设置简单,寻优能力 较强。在 GMM 训练方面,PSO 与其他群体智能优化 算法对比研究或融合有待于进一步的研究。 认30 识 算法 76 人时,HPSO 算法误识率仍低于 EM 算法。可 见HPSO 算法有效地增强了优化 GMM 参数的能力。 为了进一步从收敛过程解释 HPSO 算法的有效 性,图 3给出了实验中两种算法对 1个女性的 GMM [1] D. A. Reynolds, R. C. Rose. R identification using Gaussian mixture speaker models. IEEE Transactions on Speech and Audio Processing, 1995, 3(1): 72- 83. [2] D. A. Reynolds. Speaker identification and verification using Gaus 收敛过程。为了算法比较方便,在图 3中纵坐标 适应度均用对数似然度值,适应度值越大越好。 HPSO 算法的对数似然度值取自于每次迭代中群体的 最优值。 从图 3整个收敛过程看,本文算法在粒子搜索前 期收敛速度 sian mixture speaker models. Speech Communication, 1995, 17(1): 91-108. [3] Q. Y. Hong, S. Kwong. A genetic classification method for speaker recognition. E 将 ) ngineering Applications of Artificial Intel- ligence, 2005, 18(1): 13-19. [4] 林琳, 王树勋. 基于自适应小生境混合遗传算法的说话人识 别[J]. 电子学报, 2007, 35(1: 8-12. [5] 王金明, 张雄伟. 一种模糊高斯混合说话人识别模型[J]. 解 军理 (自然科学版), 20放 工大学学报06, 7(3): 214-219. [6] J. Kennedy, R. Eberhart. Particle swarm optimization. Proceed- ings of the IEEE International Conference on Neural N 渐减少,粒子速度变小,EM 算法很快就收敛了 到局部最优值。本文算法能够较成功地从局部最优值 跳出,进一步接近全局的最优解,从而得到更优的模 型参数。对其余说话人的 GMM训练实验,也得到同 样的趋势。 5. 结束语 etworks 1995, Piscataway: IEEE Press, 1995: 1942-1948. [7] Y. Shi, R. C. Eberhart. A modified particle swarm optimizer. IEEE International Conference on Evolutionary Computation Proceedings, Piscataway: IEEE, 1998: 69-73. [8] J. S. Garofolo, L. F. Lamel. TIMIT acoustic-phonetic continuous speech corpus, 2012. http://www.ldc.upenn.edu/Catalog |